Radio K55

Data di pubblicazione: 27/01/2026 alle 08:50

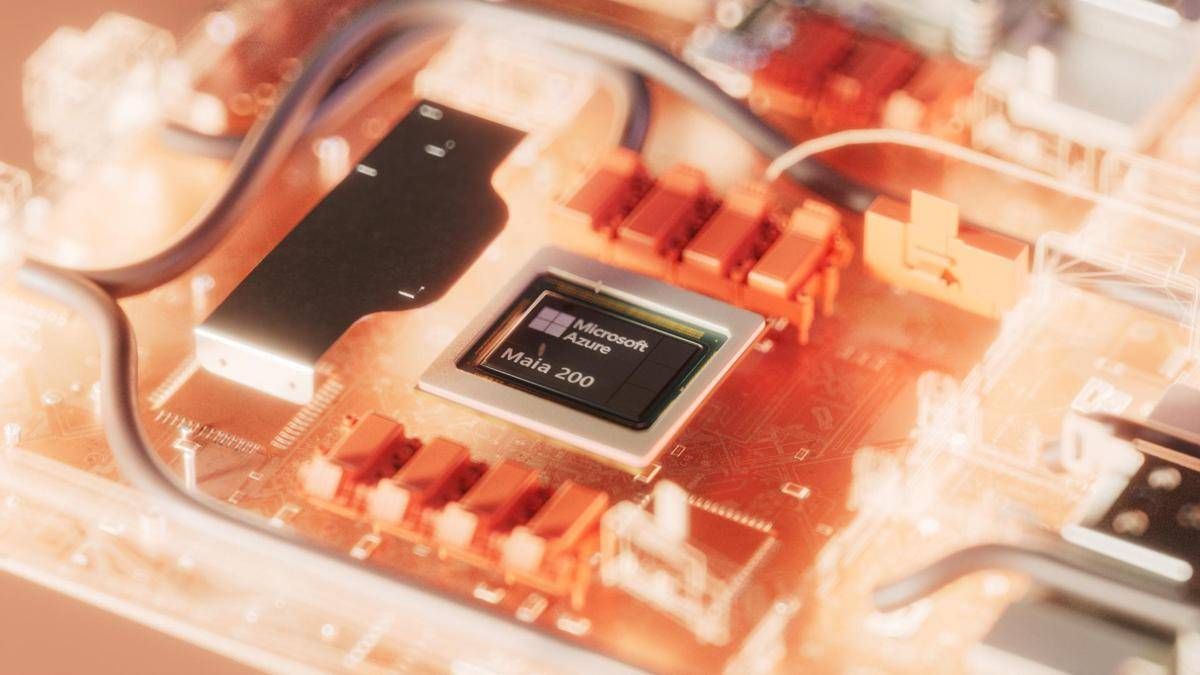

(Adnkronos) – Il settore tecnologico sta attraversando una transizione fondamentale: dalla fase di sperimentazione dei modelli di intelligenza artificiale alla creazione di un’infrastruttura solida e scalabile per l’uso reale. In questo contesto, Microsoft ha annunciato Maia 200, un acceleratore di AI di nuova generazione progettato per ottimizzare le prestazioni, ridurre i consumi energetici e abbattere i costi operativi su scala globale.

Mentre l’addestramento dei modelli (training) ha dominato il dibattito tecnologico degli ultimi anni, l’attenzione si sta ora spostando sull’inferenza. Si tratta del processo in cui l’AI risponde concretamente ai prompt, genera contenuti o supporta decisioni in tempo reale.

Maia 200 è stato sviluppato partendo dal presupposto che “l’inferenza è il momento in cui l’AI fa davvero la differenza”. Sebbene tradizionalmente sia stato utilizzato hardware generico o mutuato dal training, spesso potente ma eccessivamente costoso e poco efficiente, Maia 200 si presenta come la prima piattaforma integrata “espressamente per l’inferenza AI, con l’obiettivo di migliorare in modo significativo costo, latenza ed efficienza energetica”.

Realizzato con il processo produttivo a 3 nanometri di TSMC, ogni chip Maia 200 integra oltre 140 miliardi di transistor. L’architettura è stata ridisegnata nei suoi elementi fondamentali:

Gestione della memoria: sistema ottimizzato per mantenere i dati vicini ai core di calcolo, minimizzando i colli di bottiglia.

Networking: infrastruttura di rete potenziata per ridurre la latenza nei carichi di lavoro distribuiti.

Formati numerici: ottimizzazione di formati ridotti per elaborare i carichi di lavoro con minor dispendio energetico e di memoria.

Secondo i dati tecnici forniti, il sistema garantisce “prestazioni per dollaro migliori del 30% rispetto all’hardware di ultima generazione”, consentendo di eseguire i modelli generativi più complessi con un numero ridotto di chip e un costo per risposta inferiore.

La distribuzione dei primi sistemi Maia 200 è già stata avviata nella regione Azure US Central, con una roadmap che prevede l’espansione verso la regione US West 3 e altri nodi globali nei prossimi mesi.

L’impatto tecnologico sarà visibile direttamente nei servizi quotidiani. L’acceleratore supporterà infatti i workload di Microsoft 365 Copilot, la generazione di dati sintetici e le esperienze avanzate di Microsoft Foundry. L’obiettivo dichiarato è garantire che le capacità AI possano scalare “senza aumentare il consumo energetico o l’overhead operativo”, rendendo la tecnologia “accessibile e pronta per la vita di tutti i giorni”.

—

tecnologia

webinfo@adnkronos.com (Web Info)

Scritto da: News News

18:30 - 18:45

Selezionata dallo staff di Radio K55

18:45 - 19:30

19:30 - 20:30

1

play_arrowJohn Lennon

play_arrow

play_arrow

Imagine John Lennon

2

play_arrowEagles

play_arrow

play_arrow

Hotel California Eagles

3

play_arrowThe Doors

play_arrow

play_arrow

Light My Fire The Doors

Copyright | Radio K55 | Sede Legale: Via Lima, 41 - Roma - 00198 | P.IVA 16813261001 | Sede Operativa: Via Di Valleranello, 82 - Roma - 00128|

"WhatsAppa" con Noi